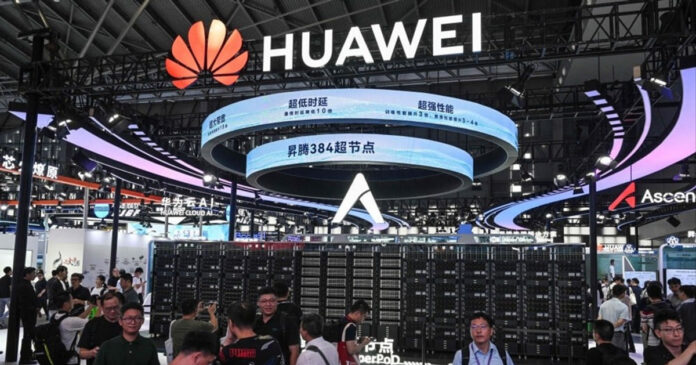

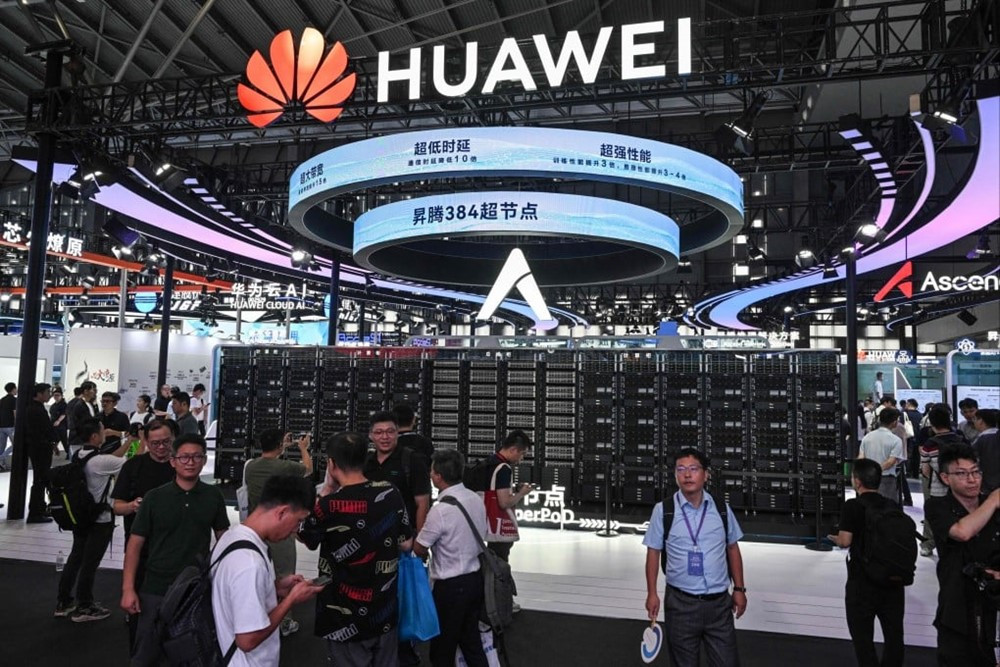

Huawei Technologies vừa ra mắt một công cụ phần mềm giúp tăng tốc quá trình suy luận của các mô hình AI lớn – bước tiến có thể hỗ trợ Trung Quốc giảm phụ thuộc vào dòng chip nhớ băng thông cao (HBM) đắt đỏ từ nước ngoài.

Tại diễn đàn Ứng dụng và Phát triển AI tài chính ở Thượng Hải (Trung Quốc) hôm 12/8, lãnh đạo Huawei chia sẻ rằng thuật toán Unified Cache Manager (UCM) cho phép phân bổ dữ liệu theo yêu cầu độ trễ khác nhau giữa các loại bộ nhớ – từ HBM siêu tốc, DRAM tiêu chuẩn đến ổ SSD – qua đó nâng cao hiệu quả xử lý suy luận.

Ông Zhou Yuefeng, phó Chủ tịch kiêm Giám đốc mảng sản phẩm lưu trữ dữ liệu của Huawei, cho biết các thử nghiệm cho thấy UCM có thể giảm tới 90% độ trễ suy luận và tăng thông lượng hệ thống gấp 22 lần.

Động thái này cho thấy các hãng công nghệ Trung Quốc đang tận dụng cải tiến phần mềm để bù đắp hạn chế trong việc tiếp cận phần cứng tiên tiến. Trước đó, startup DeepSeek của Trung Quốc cũng gây chú ý toàn cầu khi phát triển các mô hình AI mạnh mẽ dù nguồn lực chip hạn chế.

Huawei dự kiến mở mã nguồn UCM vào tháng 9, trước tiên trên cộng đồng nhà phát triển trực tuyến của hãng, sau đó là toàn ngành. Sáng kiến này có thể giúp Trung Quốc giảm phụ thuộc vào HBM nhập khẩu – thị trường hiện do SK Hynix và Samsung Electronics của Hàn Quốc, cùng Micron Technology của Mỹ, chi phối.

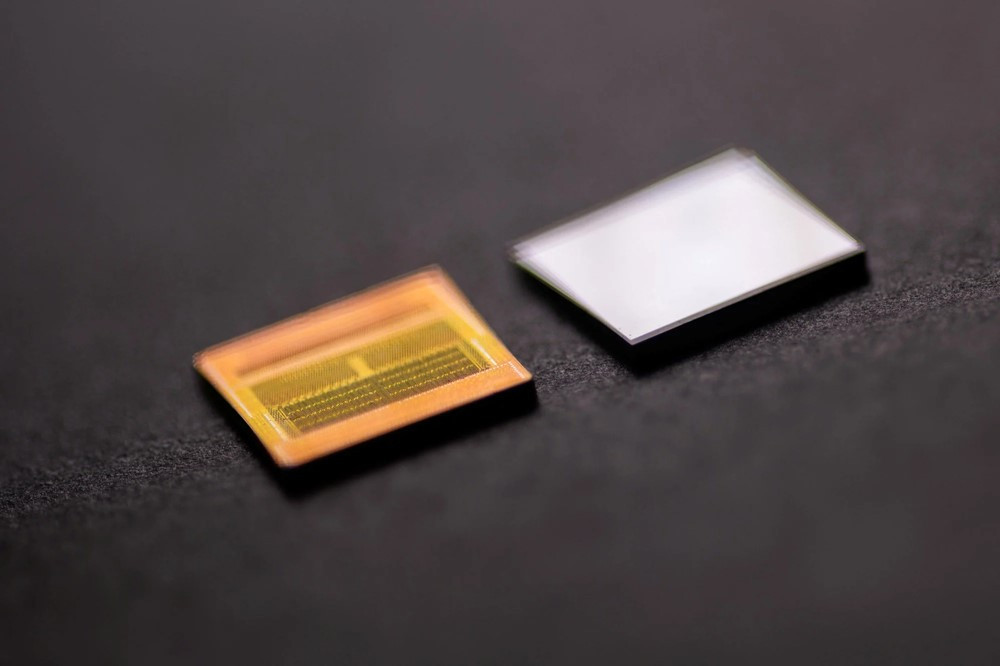

HBM là loại bộ nhớ tốc độ cao, độ trễ thấp, cung cấp băng thông dữ liệu lớn cho chip AI và giúp đạt hiệu suất tối ưu. Theo công ty tư vấn Yole Group, thị trường HBM toàn cầu dự kiến gần như tăng gấp đôi doanh thu trong năm nay, đạt 34 tỷ USD, và có thể lên 98 tỷ USD vào năm 2030 nhờ làn sóng AI.

Kể từ năm ngoái, chính quyền Mỹ đã hạn chế xuất khẩu HBM tiên tiến sang Trung Quốc trong khuôn khổ chiến lược kiềm chế ngành bán dẫn của Bắc Kinh.

Đáp lại, Trung Quốc đẩy mạnh phát triển ngành công nghiệp bộ nhớ nội địa, với các doanh nghiệp chủ chốt như Yangtze Memory Technologies, Changxin Memory Technologies và Tongfu Microelectronics.

Tuy nhiên, khoảng cách công nghệ vẫn lớn. Hầu hết công ty mới ở giai đoạn thử nghiệm và mở rộng hạ tầng cho chip HBM2, trong khi SK Hynix đã xuất xưởng HBM4 với tốc độ cao hơn.

Huawei, đang chịu lệnh trừng phạt của Mỹ, tiếp tục đóng vai trò then chốt trong nỗ lực bán dẫn của Trung Quốc với dòng chip AI Ascend. Đầu năm nay, hãng giới thiệu hệ thống tính toán AI CloudMatrix 384 với kiến trúc “siêu nút” để cạnh tranh với Nvidia GB200 NVL72.

Đến đầu tháng này, Huawei cũng tiết lộ sẽ mở mã nguồn Compute Architecture for Neural Networks – bộ công cụ phát triển phần mềm cho bộ xử lý AI Ascend – nhằm trực tiếp thách thức hệ sinh thái CUDA của Nvidia.

Theo SCMP